В наше время большие языковые модели (LLM) играют все более важную роль в получении информации и генерации ответов на запросы пользователей. Однако, иногда они могут создавать ложную информацию, которую называют галлюцинациями. Галлюцинации возникают, когда бот сталкивается с темой, с которой она не знакома, или смешивает информацию из разных источников.

В наше время большие языковые модели (LLM) играют все более важную роль в получении информации и генерации ответов на запросы пользователей. Однако, иногда они могут создавать ложную информацию, которую называют галлюцинациями. Галлюцинации возникают, когда бот сталкивается с темой, с которой она не знакома, или смешивает информацию из разных источников.

С целью борьбы с этим явлением, группа исследователей разработала новый метод, который позволяет повысить достоверность ответов модели. В состав этой группы входят кандидаты докторских наук Орион Веллер и Натаниэль Вейр, а также советники Бенджамин Ван Дурм. Для разработки метода также привлеклись Дон Лори, старший научный сотрудник Центра передового опыта в области технологий естественного языка, и Даниэль Хашаби, доцент кафедры информационных технологий.

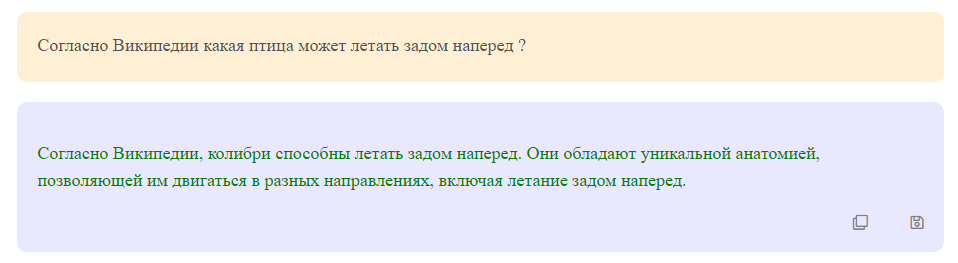

Предложенный метод включает использование подсказки "согласно" в запросах LLM. Эта подсказка позволяет моделям прямо цитировать запрашиваемый источник информации. Использование подсказки "согласно" повышает точность цитируемой информации и детализацию ответов LLM.

Например, при запросе "Согласно Википедии какая птица может летать задом наперед?" LLM может ответить: "Согласно Википедии, колибри способны летать задом наперед. Они обладают уникальной анатомией, позволяющей им двигаться в разных направлениях, включая летание задом наперед".

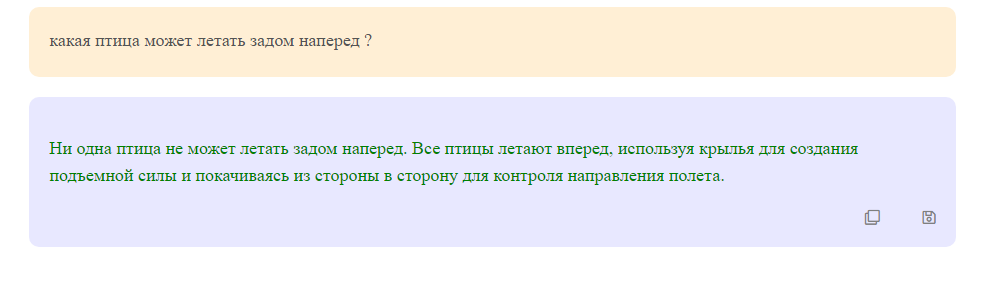

А вот как модель отвечает без волшебного слова : "какая птица может летать задом наперед ?"

Бот ответил : "Ни одна птица не может летать задом наперед. Все птицы летают вперед, используя крылья для создания подъемной силы и покачиваясь из стороны в сторону для контроля направления полета"

В случае, использования подсказки "согласно", LLM черпает информацию из конкретного источник, что повышает доверие к ответу.

Однако, важно отметить, что точность ответов модели все равно зависит от качества данных, на которых она была обучена. Если LLM обучена на недостоверных или неполных данных, то даже при использовании метода с подсказкой "согласно" вероятность галлюцинаций остается высокой.

Этот метод не представляет собой прямое решение проблемы галлюцинаций, но помогает LLM генерировать больше фактических и корректных информаций. К примеру, в области клиентского сервиса LLM может использоваться для автоматической генерации ответов на вопросы пользователей. Если LLM использует подсказку "согласно", то ответы будут иметь большую достоверность.

Предложенный метод может быть использован в различных сферах, где большие языковые модели применяются, например, в поисковых системах, голосовых помощниках, автоматизированных клиентских сервисах и других. В области медицины LLM может помочь в поиске информации о конкретных заболеваниях или симптомах с помощью подсказки "согласно".

Таким образом, методика использования подсказки "согласно" в запросах LLM является эффективным способом борьбы с галлюцинациями и повышения достоверности ответов. Она позволяет моделям цитировать определенные источники информации, что создает большую уверенность в полученных ответах. Однако, важно помнить, что качество данных, на которых обучается модель, остается ключевым фактором для достоверности ответов.